Во время открытия конференции Google I/O 2024 общий тон казался таким: «Можем ли мы получить продление?» Обещанные улучшения искусственного интеллекта от Google определенно занимают главную сцену здесь, но за некоторыми исключениями большинство из них все еще находится в процессе разработки.

Это не слишком удивительно — ведь это конференция для разработчиков. Но, кажется, потребителям придется подождать еще некоторое время, чтобы получить обещанный «Her» момент. Вот что вы можете ожидать, когда новые функции Google начнут поступать.

Искусственный интеллект в поиске Google

Кредит: Google/YouTube

Возможно, наиболее значимым дополнением для большинства людей станет расширенная интеграция Gemini в поиске Google. Хотя у Google уже была функция «генеративного поиска» в лаборатории поиска, которая могла быстро написать краткий параграф или два, вскоре каждый получит расширенную версию — «AI Overviews».

При желании в поисковых запросах AI Overviews может генерировать несколько абзацев информации в ответ на запросы, включая подзаголовки. Он также предоставит дополнительный контекст по сравнению с предыдущей версией и может принимать более подробные подсказки.

Например, если вы живете в солнечном районе с хорошей погодой и просите «рестораны рядом с вами», Обзоры могут дать вам несколько основных предложений, но также отдельный подзаголовок с ресторанами, у которых есть хорошие открытые террасы.

На более традиционной странице результатов поиска вы сможете использовать «организованные искусственным интеллектом результаты поиска», которые отказываются от традиционного SEO и интеллектуально рекомендуют веб-страницы на основе высокоспецифических запросов.

Например, вы можете попросить Google «создать трехдневный план питания без глютена с большим количеством овощей и как минимум двумя десертами», и страница поиска создаст несколько подзаголовков с ссылками на соответствующие рецепты под каждым из них.

Гугл также внедряет искусственный интеллект в поиск, с акцентом на мультимодальность — то есть вы можете использовать его не только с текстом. Конкретно, функция «Запрос с видео» находится в разработке, которая позволит вам просто направить камеру вашего телефона на объект, запросить идентификацию или помощь в ремонте и получить ответы с помощью генеративного поиска.

Google не прямо отвечал на критику относительно того, как она обрабатывает критику, что результаты поиска искусственного интеллекта фактически крадут контент из источников по всему вебу без необходимости переходить на оригинальный источник. Тем не менее, демонстранты неоднократно подчеркивали, что эти функции приводят вас к полезным ссылкам, которые вы можете проверить сами, возможно, прикрываясь перед этими критиками.

Обзоры искусственного интеллекта уже появились для пользователей Google в США, а искусственный интеллект организованных результатов поиска и запросов с видео будут доступны «в ближайшие недели».

Поискайте свои фотографии с помощью искусственного интеллекта

Кредит: Google/YouTube

Другой из более конкретных особенностей в работах — «Ask Photos», который играет с мультимодальностью, чтобы помочь вам сортировать сотни гигабайт изображений на вашем телефоне.

Скажите, ваша дочь прошла курсы плавания в прошлом году, и вы потеряли первые фотографии ее в воде. Спросите фотографии, и вы сможете просто спросить: «Когда моя дочь научилась плавать?» Ваш телефон автоматически поймет, о ком вы говорите как «ваша дочь» и покажет изображения с ее первого урока плавания.

Это похоже на поиск фотографий вашей кошки в вашей библиотеке фотографий, просто набирая «кошка», конечно, но идея в том, что мультимодальный искусственный интеллект может поддерживать более подробные вопросы и понимать, о чем вы спрашиваете с большим контекстом, с помощью Gemini и данных, уже хранящихся на вашем телефоне.

Другие детали легкие, с Ask Photos, которые должны дебютировать «в ближайшие месяцы.»

Проект Астра: искусственный интеллект в вашем кармане.

Кредит: Гугл/Ютуб

Вот здесь мы переходим к более фантастическим вещам. Проект Астра — это самый продвинутый искусственный интеллект, который мы видели до сих пор. Идея заключается в том, что вы сможете загрузить приложение Gemini на свой телефон, открыть камеру, направить ее вокруг и задавать вопросы и просить помощи на основе того, что видит ваш телефон.

Например, указывая на динамик, Астра сможет сказать вам, какие части находятся в аппаратуре и как они используются. Укажите на рисунок кошки с сомнительной жизненной силой, и Астра ответит на вашу загадку с «Котом Шрёдингера». Спросите ее, где находятся ваши очки, и если Астра ранее смотрела на них в вашем кадре, она сможет вам сказать.

Это, возможно, классическая мечта, когда речь идет об искусственном интеллекте, и довольно похожа на недавно анонсированный OpenAI GPT-4o, поэтому логично, что он еще не готов. Astra должна появиться «позднее в этом году», но любопытно, что она также должна работать на AR-очках, а не только на телефонах. Возможно, скоро мы услышим о новом носимом устройстве от Google.

Создайте индивидуальный подкаст, ведомый роботами.

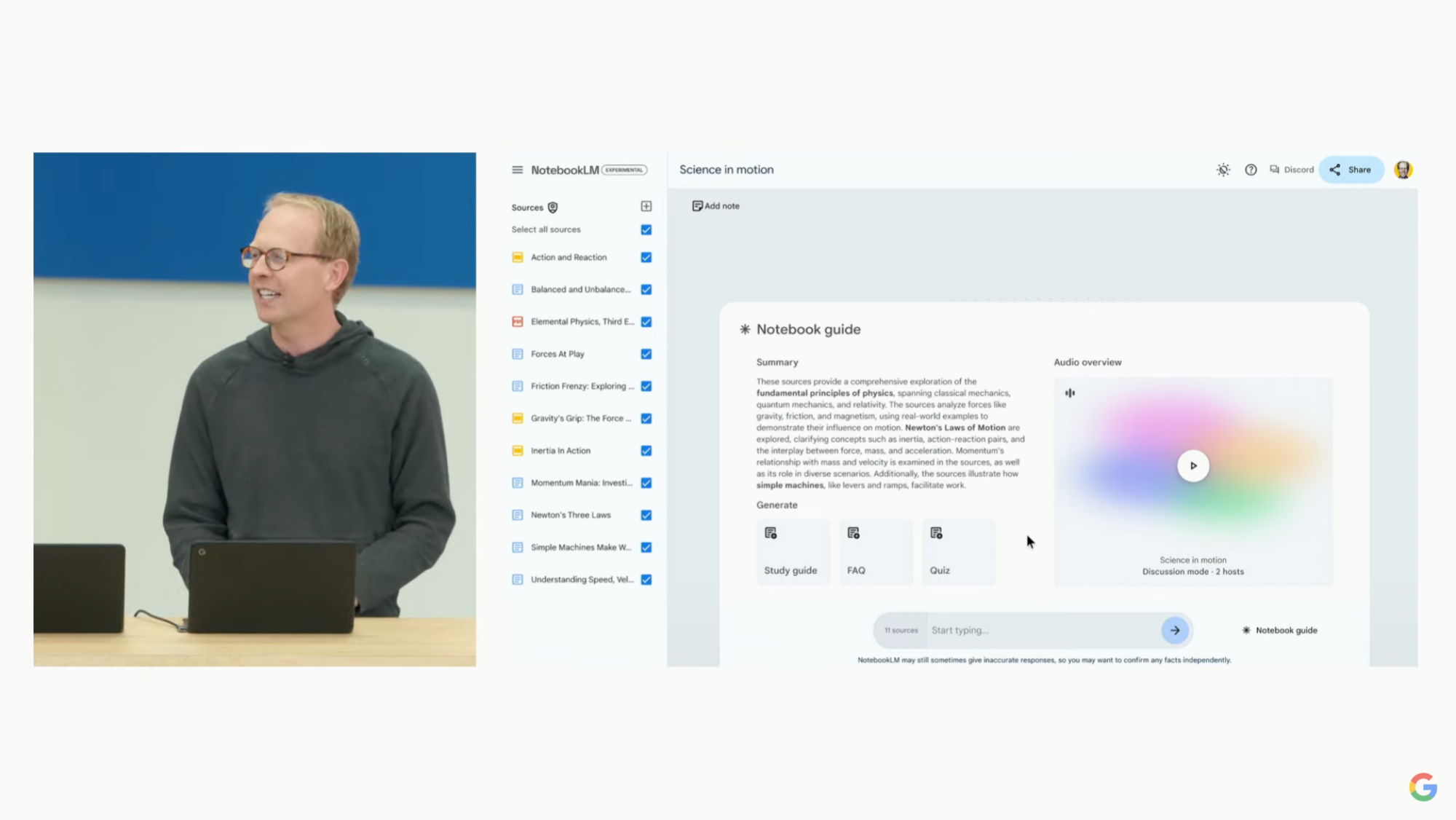

Кредит: Google/YouTube

Непонятно, когда эта функция будет готова, так как она кажется больше примером для улучшенных моделей искусственного интеллекта Google, чем главным событием, но одной из впечатляющих (и, возможно, тревожных) демонстраций, показанных Google на конференции I/O, было создание индивидуального подкаста, ведомого голосами искусственного интеллекта.

Скажите, ваш сын учится физике в школе, но больше склонен к аудио обучению, чем к текстовому. Предположительно, Gemini скоро позволит вам загружать письменные PDF-файлы в приложение NotebookLM от Google и просить Gemini создать аудио программу, обсуждающую их. Приложение будет генерировать подкаст, ведомый искусственным интеллектом, который будет естественно говорить о темах из PDF-файлов.

Ваш сын сможет в любое время прервать хозяев, чтобы попросить уточнения.

Галлюцинация явно является серьезной проблемой здесь, и естественный язык может быть немного «смущающим», если не сказать больше. Но нет сомнений, что это впечатляющий показ… если бы мы только знали, когда сможем воссоздать его.

Оплаченные функции

Кредит: Google/YouTube

Есть несколько других инструментов, которые кажутся созданными специально для типичного потребителя, но пока они будут ограничены платным рабочим пространством Google (и в некоторых случаях планами Google One AI Premium).

Самым многообещающим из них является интеграция с Gmail, которая использует трехступенчатый подход. Первый — это резюме, которые могут прочитать цепочку писем в Gmail и разбить ее на ключевые моменты для вас. Это не слишком новаторский подход, как и второй — позволение ИИ предлагать контекстные ответы на основе информации из ваших других писем.

Но Gemini Q&A кажется действительно трансформационным. Представьте, что вы ищете крышные работы и уже отправили три различные строительные фирмы для получения предложений. Теперь вы хотите создать таблицу с каждой фирмой, их ценами и доступностью. Вместо того, чтобы просматривать каждое письмо с ними, вы можете попросить Gemini box внизу Gmail создать эту таблицу для вас. Он будет искать в вашем почтовом ящике Gmail и создавать таблицу в течение нескольких минут, экономя ваше время и, возможно, помогая вам найти пропущенные письма.

Этот вид контекстного построения таблиц также будет доступен в приложениях, не связанных с Gmail, но Google также гордится своим новым «Виртуальным напарником, работающим на Gemini». Находясь еще на ранних стадиях разработки, эта предстоящая функция Workspace является своеобразной смесью типичного чата Gemini и Astra. Идея заключается в том, что организации смогут добавлять в свои аналоги Slack искусственных интеллектуальных агентов, которые будут находиться на связи для ответа на вопросы и создания документов круглосуточно.

Функции резюмирования, работающие на основе Gemini, будут внедрены в этом месяце для пользователей Workspace Labs, а другие функции Gmail появятся в Лаборатории в июле.

Драгоценные камни

Кредит: Google/YouTube

Ранее в этом году OpenAI заменила плагины ChatGPT на «GPTs», позволяя пользователям создавать настраиваемые версии своих чатботов ChatGPT, способных обрабатывать конкретные вопросы. Gems — это ответ Google на это, и они работают относительно похожим образом. Вы сможете создать несколько Gems, каждый из которых будет иметь свою собственную страницу в интерфейсе Gemini, и каждый будет отвечать на определенный набор инструкций. В демонстрационной версии Google были предложены примеры, такие как «Yoga Bestie», предлагающий советы по упражнениям.

Драгоценные камни — это еще одна особенность, которая не увидит света дня до нескольких месяцев, так что пока придется оставаться с GPTs.

Агенты

Кредит: Гугл/Ютуб

Свежий после молчаливого приема Humane AI Pin и Rabbit R1 , поклонники искусственного интеллекта надеялись, что на Google I/O будет показан ответ Gemini на обещания, стоящие за этими устройствами, то есть способность выходить за рамки простого сбора информации и фактически взаимодействовать с веб-сайтами за вас. Но мы получили только небольшое пробное представление без установленной даты выпуска.

На презентации от генерального директора Google Сундара Пичаи мы увидели намерение компании создать искусственный интеллект, который может «думать за несколько шагов вперед». Например, Пичаи говорил о возможности будущего Google AI Agent помочь вам вернуть обувь. Он может начать с «поиска квитанции в вашем почтовом ящике», а затем перейти к «заполнению формы возврата» и «назначению забора», все под вашим наблюдением.

Все это имело огромное ограничение в том, что это не была демонстрация, а просто пример того, над чем хочет работать Google. «Представьте, если бы Gemini могла» сделать много тяжелой работы во время этой части мероприятия.

Новые модели искусственного интеллекта Google

Кредит: Google/YouTube

В дополнение к выделению конкретных функций, Google также приветствовал выпуск новых моделей искусственного интеллекта и обновлений существующих моделей. От генеративных моделей, таких как Imagen 3, до более крупных и контекстно интеллектуальных версий Gemini, эти аспекты презентации были предназначены скорее для разработчиков, чем для конечных пользователей, но всё же есть несколько интересных моментов, которые можно выделить.

Ключевые особенности — это введение Veo и Music AI Sandbox, которые генерируют искусственный интеллект для видео и звука соответственно. Пока нет слишком много деталей о том, как они работают, но Google привлекла к этому крупных звезд, таких как Дональд Гловер и Уайклифф Джин, для обещающих цитат, таких как «Каждый станет режиссером» и «Мы просматриваем бесконечные ящики».

На данный момент лучшие демонстрации, которые у нас есть для этих генеративных моделей, находятся в примерах, опубликованных на каналах знаменитостей на YouTube. Вот один из них ниже:

Гугл также не переставал говорить о Gemini 1.5 Pro и 1.5 Flash во время своей презентации, новых версиях его LLM, в первую очередь предназначенных для разработчиков, которые поддерживают большее количество токенов, позволяя учитывать больше контекста. Вероятно, это не будет иметь большого значения для вас, но обратите внимание на Gemini Advanced.

«Gemini Advanced» уже на рынке как платный план Google, и позволяет задавать большее количество вопросов, некоторое взаимодействие с Gemini 1.5 Pro для непрограммистов, интеграцию с различными приложениями, такими как Docs (включая некоторые, но не все функции, объявленные сегодня для Workspace), и загрузку файлов, таких как PDF.

Некоторые обещанные функции Google звучат так, будто для их использования вам понадобится подписка на Gemini Advanced, в частности те, которые требуют загрузки документов, чтобы чатбот мог отвечать на вопросы, связанные с ними, или использовать их для своего собственного контента. Мы пока не знаем точно, что будет бесплатным, а что нет, но это еще одно предостережение, которое стоит иметь в виду при обещаниях Google «следите за нами» на этом I/O.

Это завершает общие объявления Google о Gemini. Тем не менее, они также сделали объявления о новых функциях искусственного интеллекта в Android, включая новую возможность «Круг для поиска» и использование Gemini для обнаружения мошенничества. (Но это не новости о Android 15: они будут завтра.)